메타는 2023년 페이스북과 인스타그램의 핵심 구성 요소인 순위 및 추천 모델을 지원하기 위해 설계된 첫 번째 자체 AI 추론 가속기를 공개함.

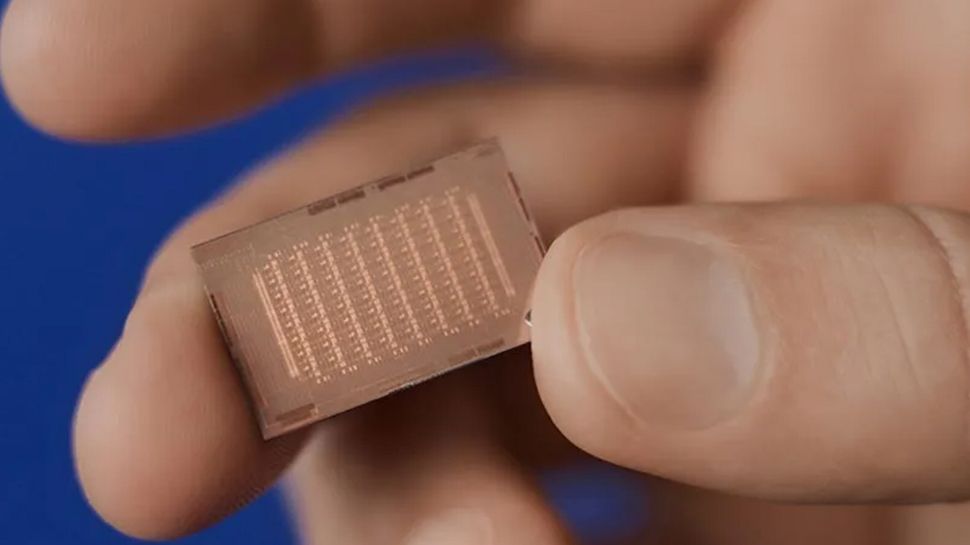

메타 훈련 및 추론 가속기(MTIA) 칩은 추론을 처리할 수 있지만 훈련은 처리할 수 없으며, 4월에 업데이트되어 첫 번째 솔루션의 컴퓨팅 및 메모리 대역폭을 두 배로 늘림.

지난달 열린 핫 칩 심포지엄에서 메타는 차세대 MTIA에 대한 발표를 하였고, 추천 엔진에 GPU를 사용하는 것이 도전 과제가 없지 않다고 인정함. 소셜 미디어 거인은 최대 성능이 항상 효과적인 성능으로 이어지지 않으며, 대규모 배포는 자원 집약적일 수 있고, 용량 제약은 생성 AI에 대한 수요 증가로 인해 악화된다고 언급함.

이러한 점을 고려하여 메타의 차세대 MTIA 개발 목표는 이전 세대에 비해 TCO 및 와트당 성능을 개선하고, 여러 메타 서비스에서 모델을 효율적으로 처리하며, 개발자 효율성을 높여 고용량 배포를 신속하게 달성하는 것임.

메타의 최신 MTIA는 GEN-O-GEN을 통해 성능이 크게 향상되며, BF16에서 GEMM TOPs를 3.5배 증가시켜 177 TFLOPS에 도달하고, FP32와 유사한 정확도를 위한 하드웨어 기반 텐서 양자화를 제공하며, PyTorch Eager Mode에 대한 최적화된 지원으로 작업 시작 시간을 1마이크로초 이하로 줄이고 작업 교체 시간을 0.5마이크로초 이하로 단축함. 또한 TBE 최적화는 임베딩 인덱스의 다운로드 및 프리패치 시간을 개선하여 이전 세대에 비해 2-3배 더 빠른 실행 시간을 달성함.

MTIA 칩은 TSMC의 5nm 공정으로 제작되었으며, 1.35GHz에서 작동하고 게이트 수는 23억 개이며, 354 TOPS(INT8) 및 177 TOPS(FP16) GEMM 성능을 제공하며, 204.8GB/s의 대역폭을 가진 128GB LPDDR5 메모리를 사용하고, 모두 90와트 TDP 내에서 작동함.

처리 요소는 RISC-V 코어를 기반으로 하며, 스칼라 및 벡터 확장을 특징으로 하고, 메타의 가속기 모듈에는 듀얼 CPU가 포함됨. 핫 칩 2024에서 ServeTheHome는 PCIe 스위치 및 CPU와 연결된 메모리 확장을 발견함. 이게 CXL인지에 대한 질문에 메타는 다소 수줍게 “섀시에서 메모리를 추가하는 옵션이지만 현재 배포되고 있지 않다”고 답함.

/cdn.vox-cdn.com/uploads/chorus_asset/file/25614140/Google_Chrome_browser_tab_sync_updates.jpg)